目录

0.前期准备:更改主机名

[root@BigDataHadoopHS4PRD ~]# cat /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=BigDataHadoopHS4PRD

1.设置/etc/hosts文件(CDH集群内所有主机都要配置)-此处给HiveServer4

备份配置文件:

[root@BigDataHadoopHS4PRD ~]# cp /etc/hosts /etc/hosts.bak_$(date +%Y%m%d)

修改:

[root@BigDataHadoopHS4PRD ~]# cat >> /etc/hosts <<EOF 172.18.2.50 BigDataHadoopCMPRD 172.18.2.38 BigDataHadoopNN1PRD 172.18.2.39 BigDataHadoopNN2PRD 172.18.2.40 BigDataHadoopDN1PRD 172.18.2.41 BigDataHadoopDN2PRD 172.18.2.42 BigDataHadoopDN3PRD 172.18.2.43 BigDataHadoopDN4PRD 172.18.2.72 BigDataHadoopDN5PRD 172.18.2.73 BigDataHadoopHS4PRD EOF

其他CM机和CDH主机需要增加:

[root@BigDataHadoopHS4PRD ~]# cat >> /etc/hosts <<EOF 172.18.2.73 BigDataHadoopHS4PRD EOF

2.修改主机ulimit配置

备份配置文件:cp /etc/security/limits.conf /etc/security/limits.conf_$(date +%Y%m%d)

修改:

[root@BigDataHadoopHS4PRD ~]# cat >> /etc/security/limits.conf <<EOF ########### limits for Hadoop ############# * soft nproc 131072 * hard nproc 131072 * soft nofile 655360 * hard nofile 655360 ########### limits for Hadoop ############# EOF

3.禁用selinux(CDH集群内所有主机都要配置)-此处给HiveServer4

即时禁用:setenforce 0

开机禁用:修改/etc/selinux/config文件,SELINUX值为disabled

备份配置文件:

cp /etc/selinux/config /etc/selinux/config_$(date +%Y%m%d)

修改:

sed -i 's/SELINUX=enforcing/SELINUX=disabled/' /etc/selinux/config

4.关闭防火墙(CDH集群内所有主机都要配置)

即时关闭:

service iptables stop service ip6tables stop

开机关闭:

chkconfig iptables off chkconfig ip6tables off

5.修改主机参数交换区和透明大页面参数(CDH集群内所有主机都要配置)-此处给HiveServer4

(1)配置即时生效:

[root@BigDataHadoopHS4PRD ~]# echo 0 > /proc/sys/vm/swappiness [root@BigDataHadoopHS4PRD ~]# echo never > /sys/kernel/mm/transparent_hugepage/defrag [root@BigDataHadoopHS4PRD ~]# echo never > /sys/kernel/mm/transparent_hugepage/enabled

(2)配置重启后生效:

修改/etc/sysctl.conf文件:vm.swappiness=0

备份配置文件:

cp /etc/sysctl.conf /etc/sysctl.conf_$(date +%Y%m%d)

修改

[root@BigDataHadoopHS4PRD ~]# cat >> /etc/sysctl.conf<<EOF vm.swappiness=0 EOF

(3)修改/etc/rc.d/rc.local文件,

备份配置文件:cp /etc/rc.d/rc.local /etc/rc.d/rc.local_$(date +%Y%m%d)

配置文件增加以下内容:

[root@BigDataHadoopHS4PRD ~]# echo never > /sys/kernel/mm/transparent_hugepage/defrag [root@BigDataHadoopHS4PRD ~]# echo never > /sys/kernel/mm/transparent_hugepage/enabled

修改配置文件:

[root@BigDataHadoopHS4PRD ~]# cat >> /etc/rc.d/rc.local <<EOF echo never > /sys/kernel/mm/transparent_hugepage/defrag echo never > /sys/kernel/mm/transparent_hugepage/enabled EOF

6.集群时钟同步(CDH集群内所有主机都要配置)

配置时间同步服务器

(1)修改/etc/ntp.conf文件(先备份:cp /etc/ntp.conf /etc/ntp.conf_$(date +%Y%m%d))

vim /etc/ntp.conf增加配置:server 172.18.1.254 iburst

(2)修改/etc/sysconfig/ntpdate文件,SYNC_HWCLOCK=yes

备份配置文件:cp /etc/sysconfig/ntpdate /etc/sysconfig/ntpdate_$(date +%Y%m%d)

修改:sed -i 's/SYNC_HWCLOCK=no/SYNC_HWCLOCK=yes/' /etc/sysconfig/ntpdate

(3)启动ntpd服务:service ntpd start

7.安装httpd(CM主机执行)——新增数据节点无需安装

8.配置内网CM YUM源(CDH集群内所有主机都要配置)-此处给HiveServer4

[root@BigDataHadoopHS4PRD ~]# cat > /etc/yum.repos.d/cm.repo << EOF [CM] name=CM baseurl=http://172.18.2.50/CM/cm/5.14.2/ gpgcheck=0 enabled=1 EOF 或 [root@BigDataHadoopHS4PRD ~]# cat > /etc/yum.repos.d/cloudera-manager.repo << EOF [cloudera-manager] name = Cloudera Manager, Version 5.14.2 baseurl = http://172.18.2.50/CM/cm/5.14.2/ gpgcheck = 0 EOF 同时加入如下源(本地iso源,用于安装依赖项): [root@BigDataHadoopHS4PRD ~]# cat > /etc/yum.repos.d/iso.repo <<EOF [rhel-source] name=Red Hat Enterprise Linux $releasever - $basearch - Source baseurl=http://172.18.2.48/iso enabled=1 gpgcheck=0 EOF

9.安装mariadb——数据节点无需安装

10.安装mysql connect jdbc jar包(所有主机都要安装)

[root@BigDataHadoopHS4PRD ~]# mkdir -p /usr/share/java #上传mysql-connector-java-5.1.42-bin.jar 到 /usr/share/java目录 [root@BigDataHadoopHS4PRD ~]# ln -sv /usr/share/java/mysql-connector-java-5.1.42-bin.jar /usr/share/java/mysql-connector-java.jar

三、CM/CDH安装

1.所有主机安装cm server和jdk

创建目录:

[root@BigDataHadoopHS4PRD java]# mkdir -p /usr/java

上传jdk-8u121-linux-x64.tar到/usr/java目录

解压:

[root@BigDataHadoopHS4PRD java]#tar xvf /usr/java/jdk-8u121-linux-x64.tar

配置jdk目录

cp /etc/profile /etc/profile.bak_$(date +%Y%m%d)

vi /etc/profile

增加下面内容

export JAVA_HOME=/usr/java/jdk1.8.0_121

export JRE_HOME=$JAVA_HOME/jre

export PATH=$JAVA_HOME/bin:$PATH

2.mariadb建立cm server元数据库,并赋权给cm用户

3. mariadb建立CM监控组件数据库并赋权

4. mariadb建立CDH组件数据库并赋权

5.初始化CM元数据库(2.68就是mysql数据库,2.48,-2.49)

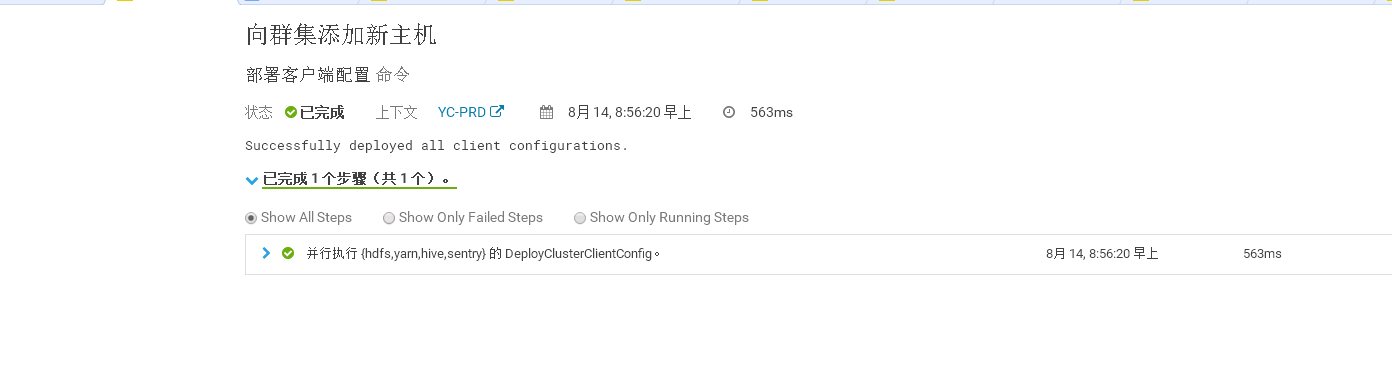

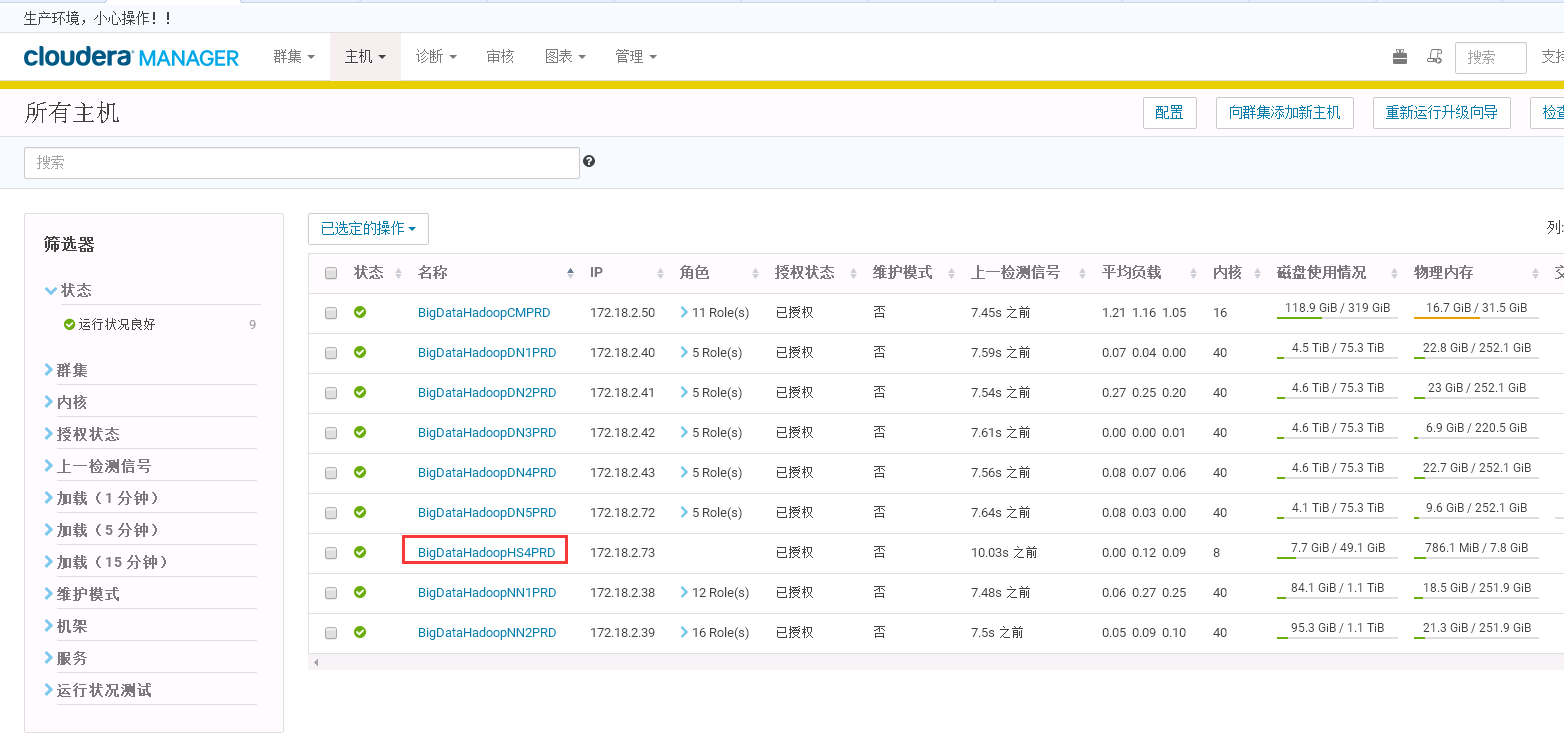

6.开始扩容CDH

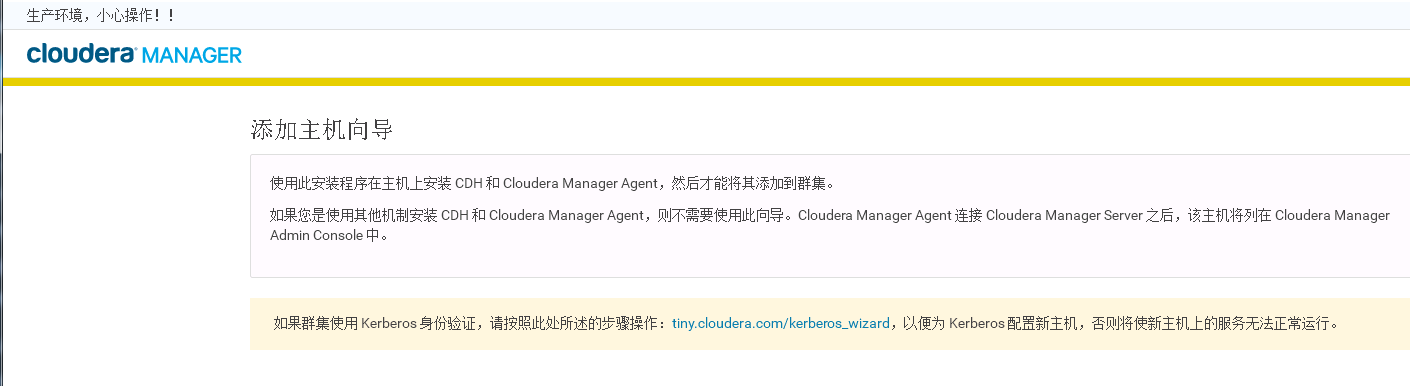

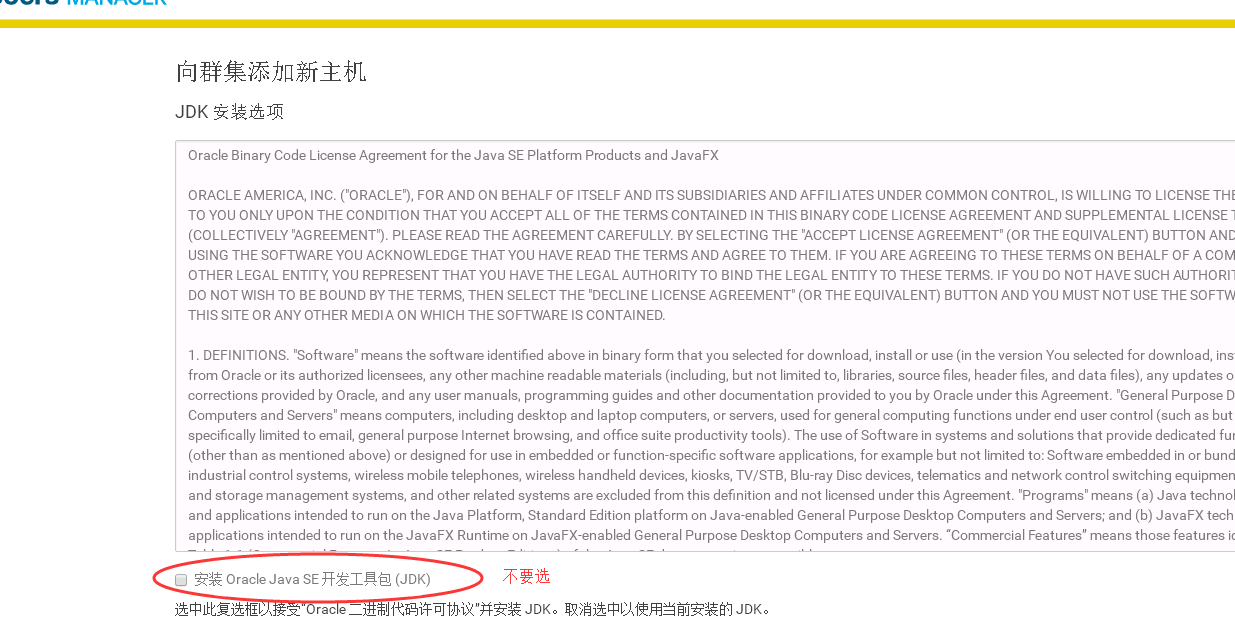

6.1 登录cm,选择主机->向集群添加主机(Hiveserver2安装)

输入自定义存储库:http://172.18.2.50/CM/cm/5.14.2

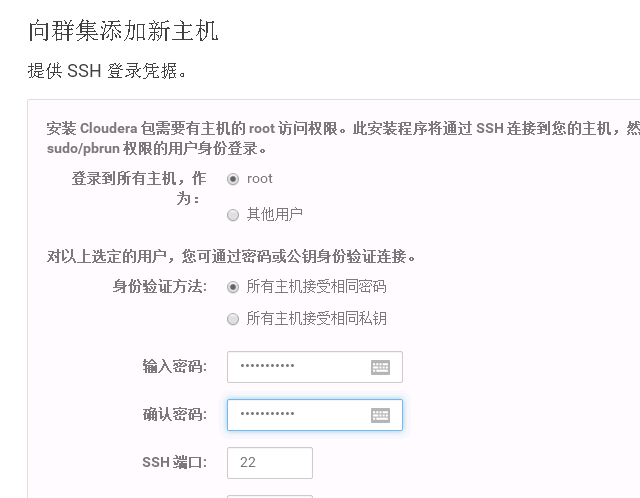

输入密码:

安装可能会出现安装错误,通过加载本地iso源:https://www.topunix.com/post-1139.html

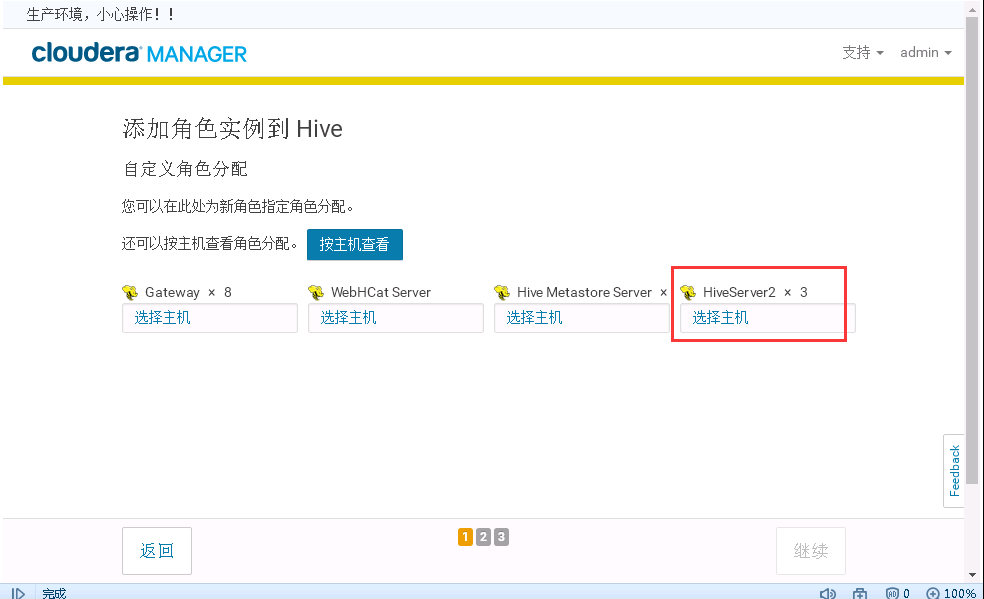

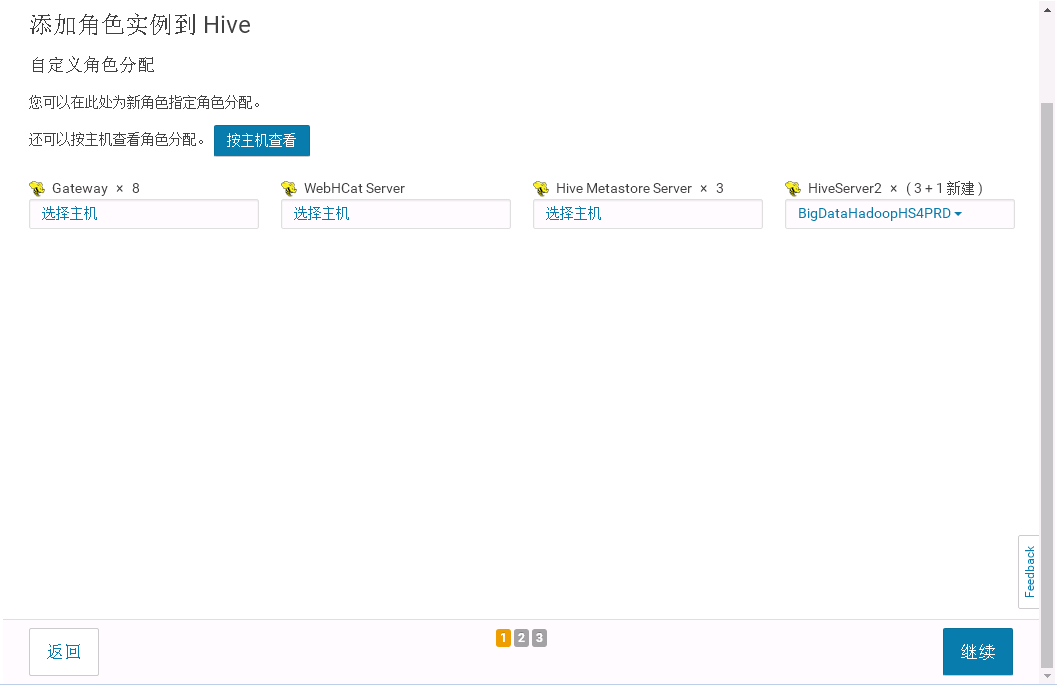

6.2 选择角色HIVE,增加角色实例;

6.3 启动实例

启动失败:

查找日志,发现主机内存只有8G,不满足要求,升配置32G,启动成功

6.3 高可用配置

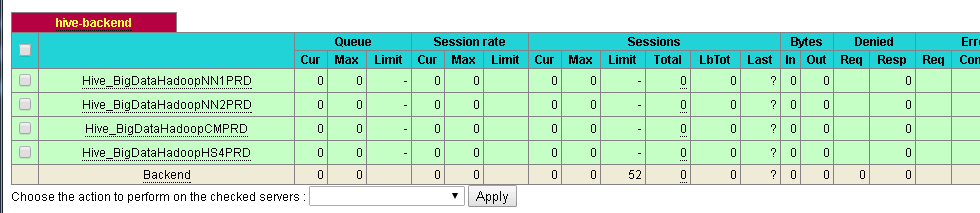

hiveserver2使用的是HAproxy的负载均衡,在172.18.2.67的haproxy加入高可用配置

进入连接查看:http://172.18.2.67:9100/haproxy-stats

用户名和密码再[root@Bigdata_HAProxy_1_PRD ~]# cat /etc/haproxy.cfg中的listen status查看

用户名:admin

密码:stats

6.4 重启前

6.5 重启后,新节点已经增加

service haproxy restart

文章评论